DL03

Neural Network

- 데이터들이 weight으로 연결되어 있다.

- 예측값이 강하다면 해당 노드가 활성화되어 있는 것이다.

Classification problem

- 원공간을 2개의 부분공간으로 나누는 선형 함수를 찾는 것이 목표이다.

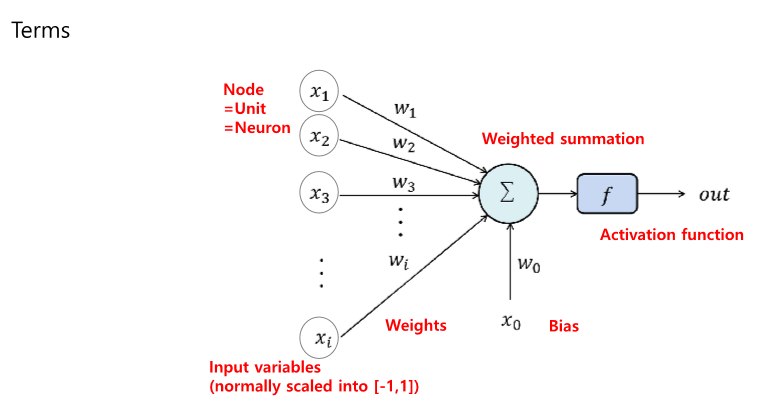

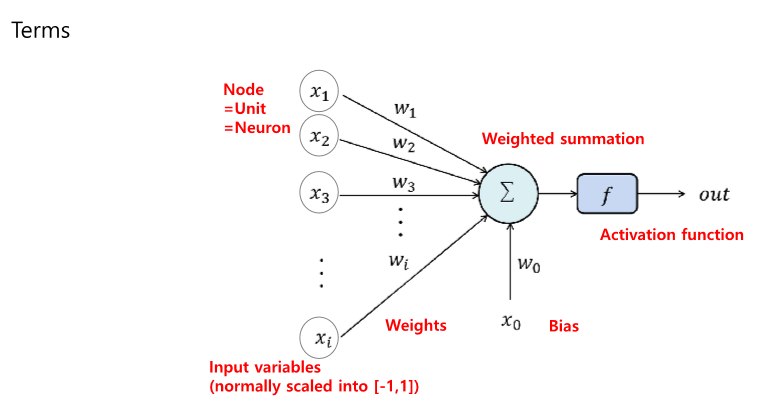

용어들

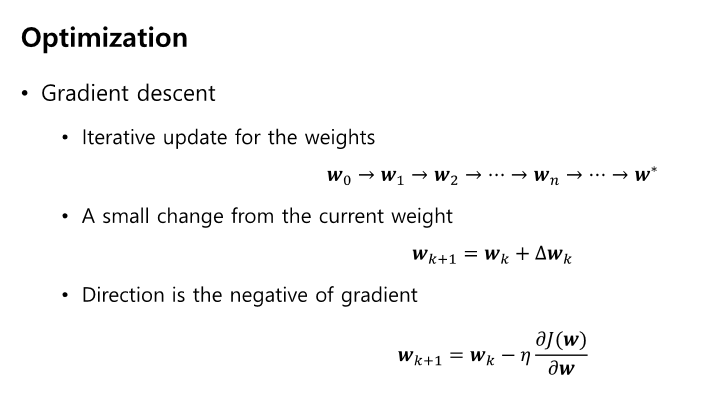

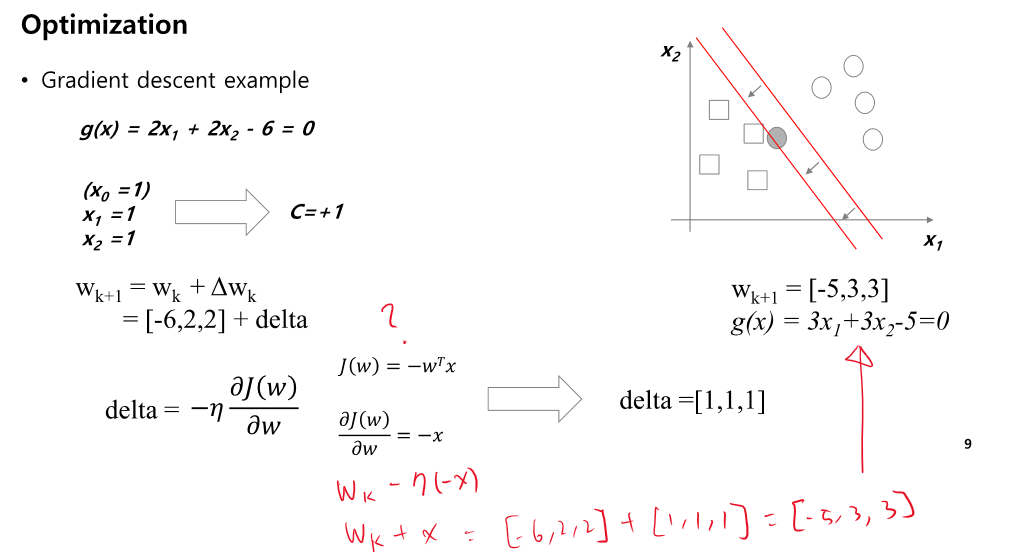

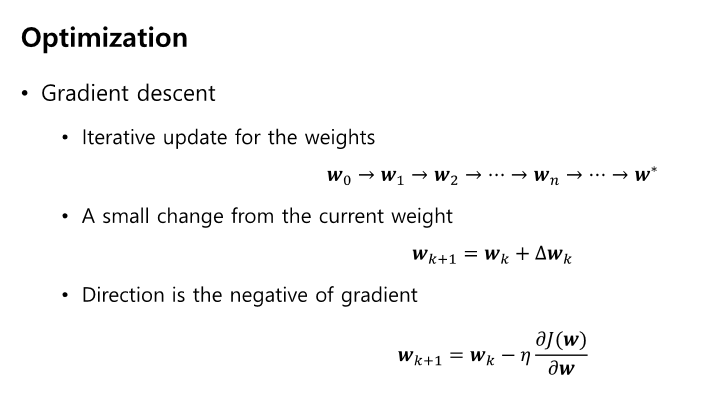

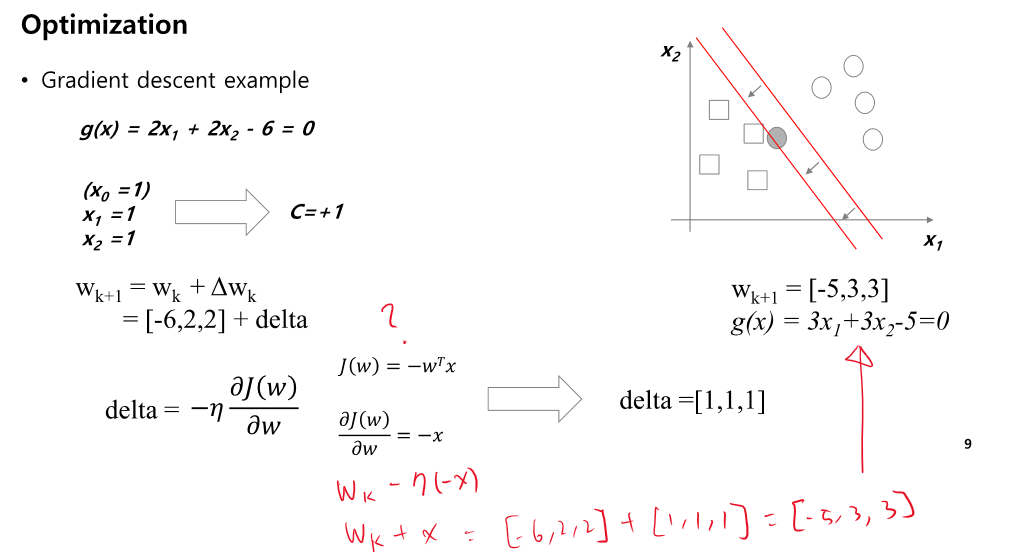

최적화

- 데이터 포인트가 매우 잘못 분류되어있다면 gradient 또한 매우 크다

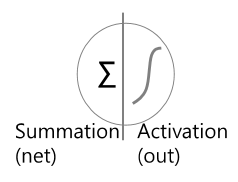

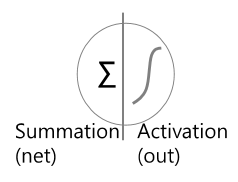

Perceptron

- 인간의 신경망과 닮은 신경망을 구성하여 학습시킨다.

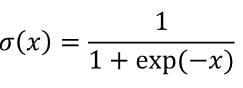

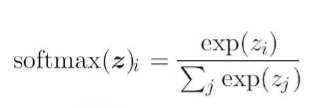

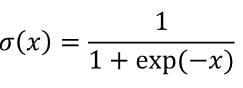

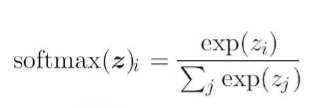

Activation Function

- Sigmoid(Logistic)

- tanh

- ReLU

- Activation function을 쓰는 이유?

- activation function을 안 쓰면 아무리 층을 깊게 구성해도 f(ax+by) = af(x)+bf(y)의 성질을 가졌기 때문에 결국은 1개의 층으로 표현이 가능해서 층을 깊게 쌓을 수 없기 때문에 data를 비선형으로 만들어서 층을 깊게 쌓기 위해서 쓴다.

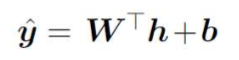

MLP

- MLP는 Perceptron에서 풀지 못했던 비선형 문제를 여러개의 선형 문제로 층을 나누어서 학습하고 풀수 있다.

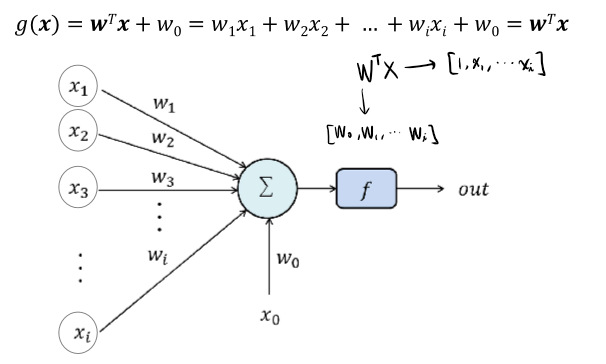

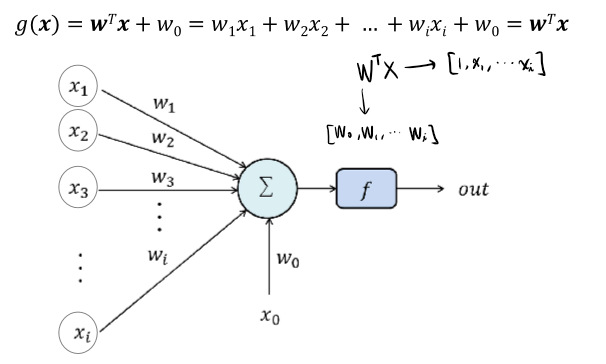

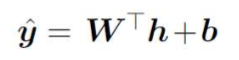

- 각 노드 표현식

- 각 층에서의 weight의 개수 : (x + 1) * y, only if x is number of input, y is number of output

Activation Function on Output layer

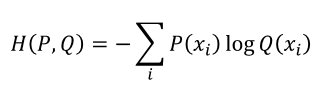

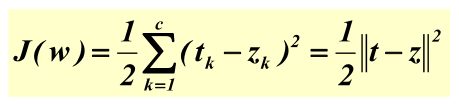

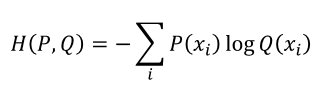

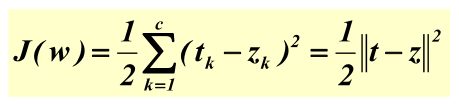

Loss Function

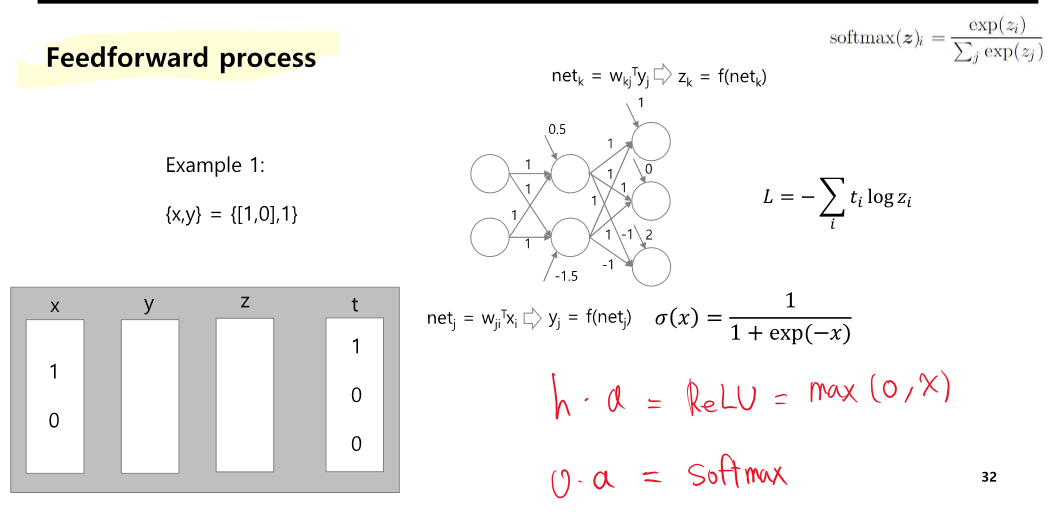

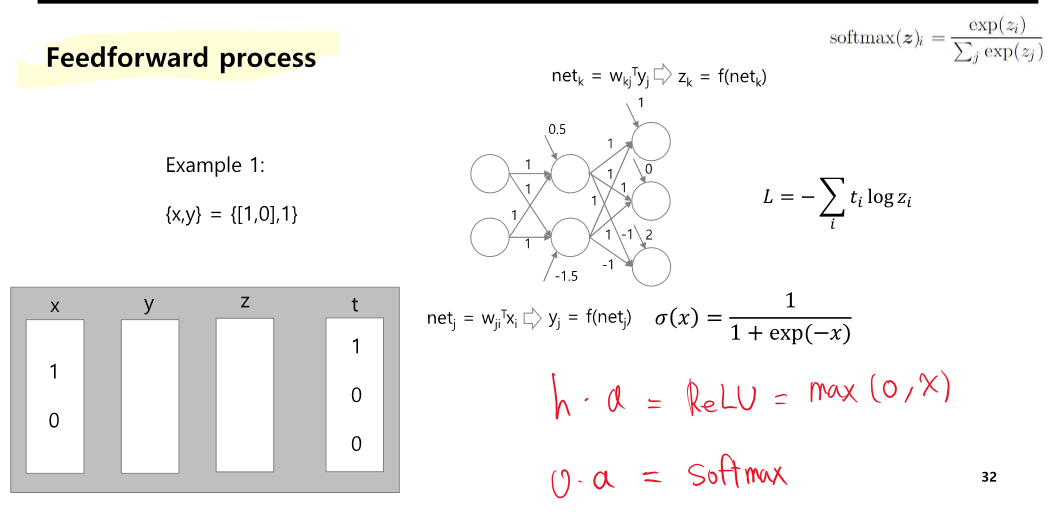

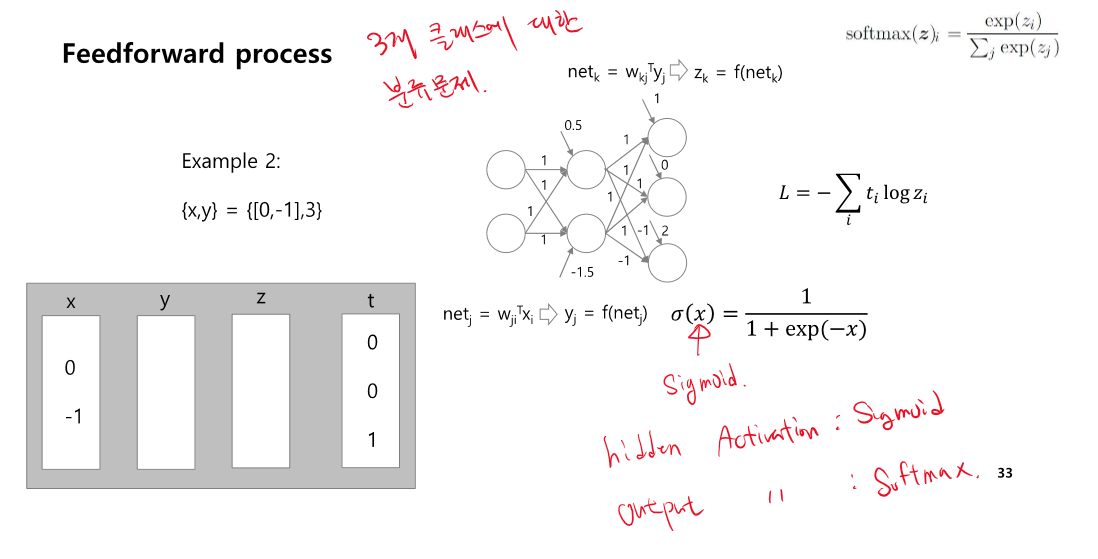

Feedforward Process

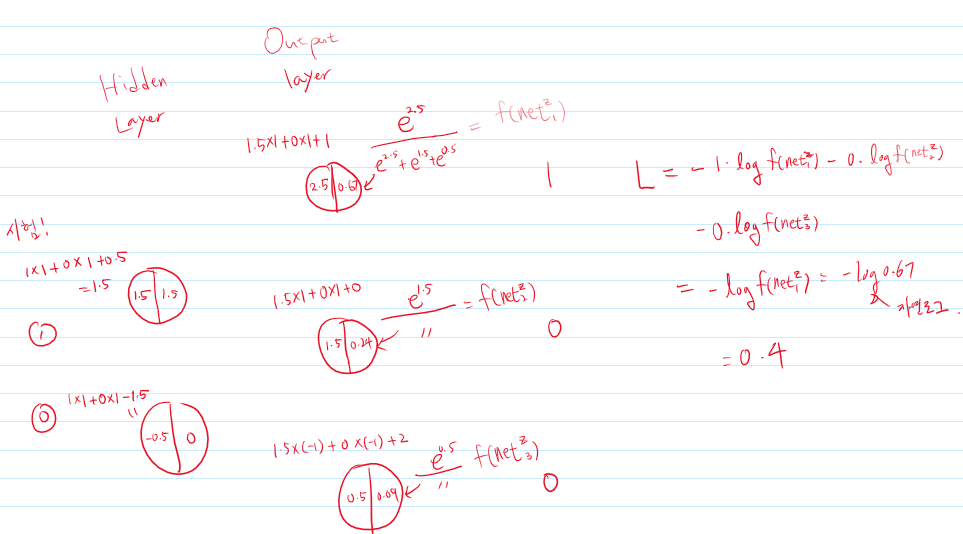

문제 (1)

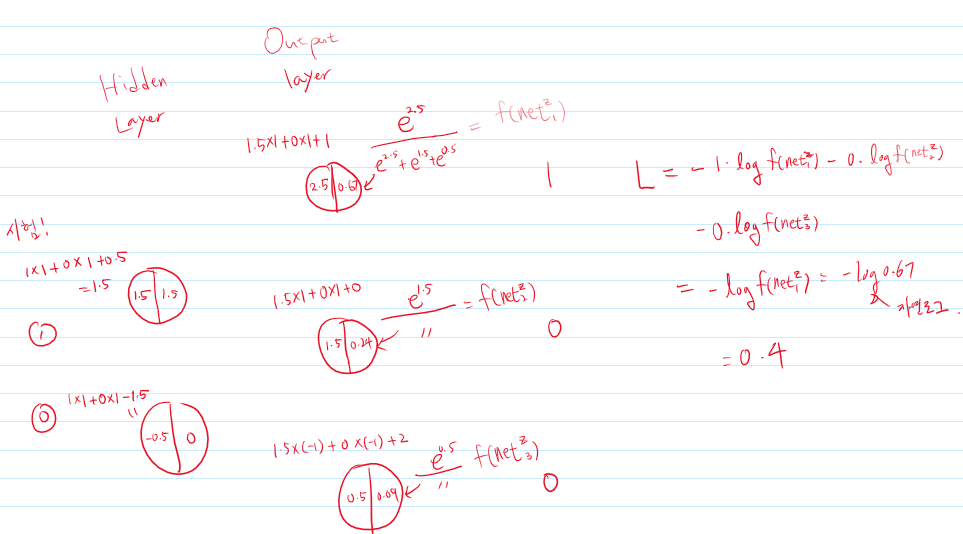

정답 (1)

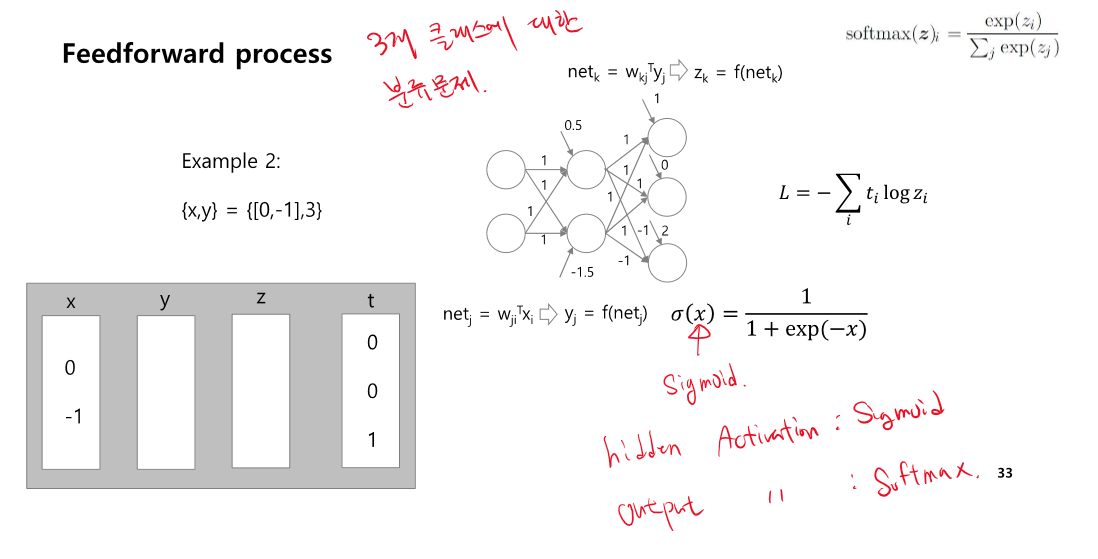

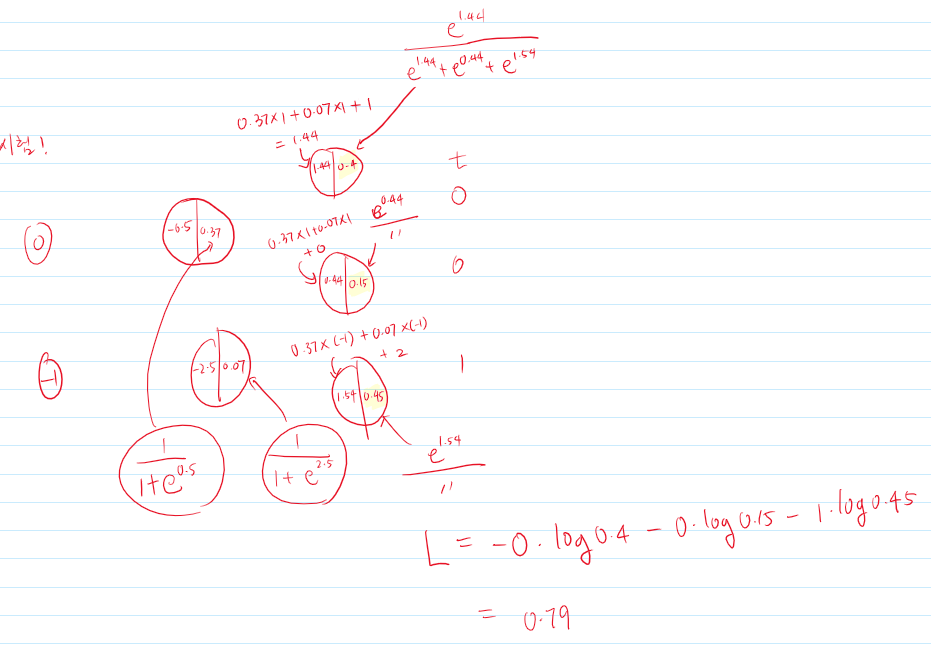

문제 (2)

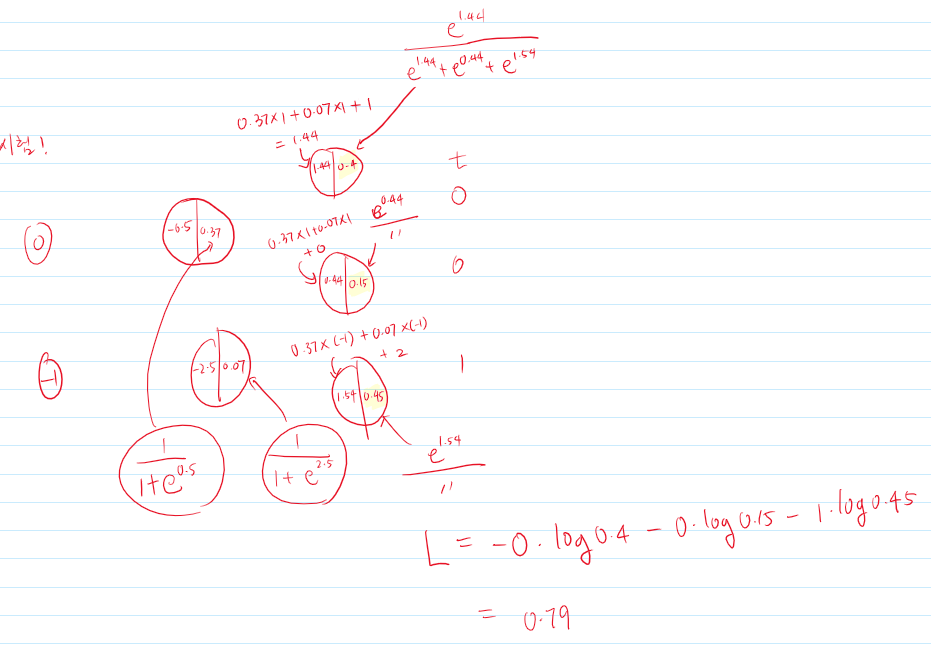

정답 (2)

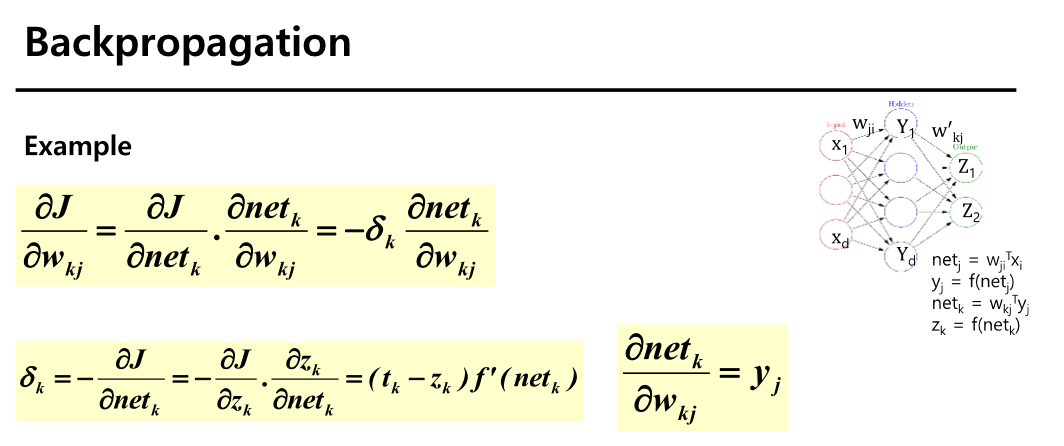

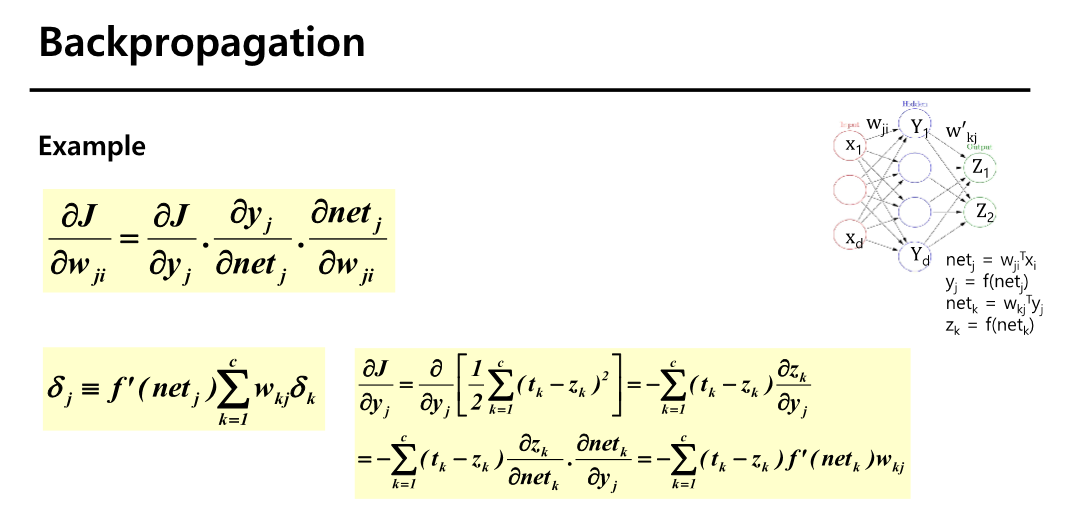

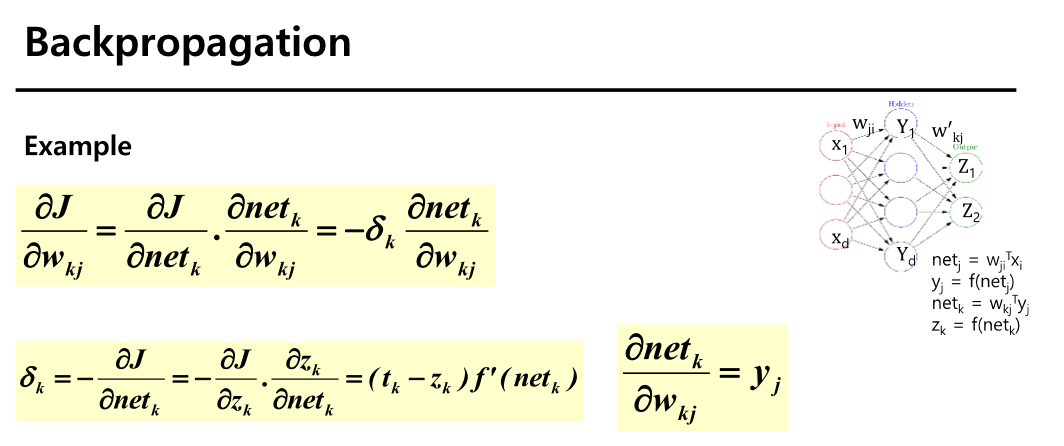

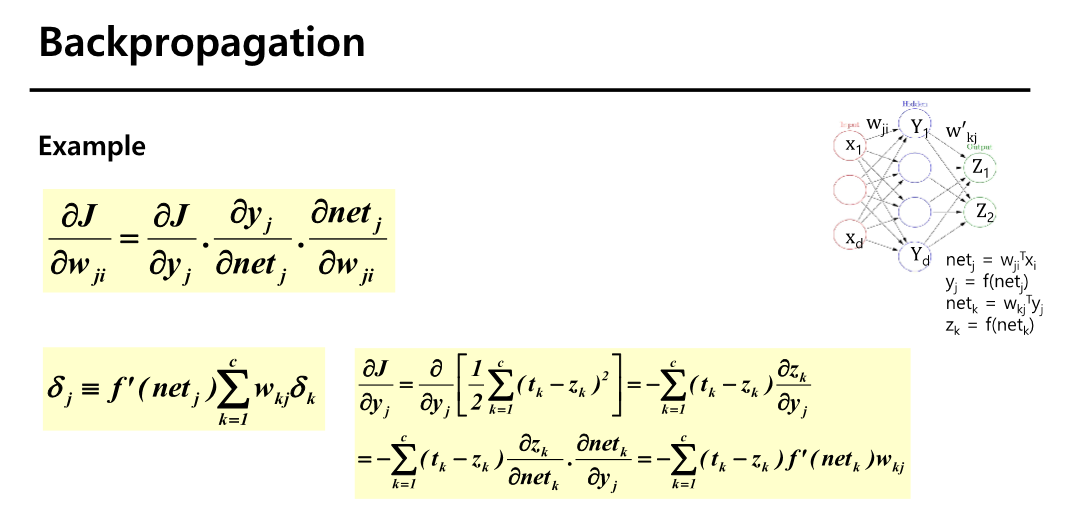

BackPropagation

- Weight를 최적화하는 과정

- 최적의 weight를 어떻게 찾는가?

- Feedforward

- 피드포워드 작업은 출력 단위를 얻기 위해 입력 장치에 패턴을 제시하고 네트워크를 통한 신호 전달하는 작업이다.

- 학습

- 계산된 출력과 원하는 출력 사이의 거리를 줄이기 위한 매개변수를 찾는 과정

편미분